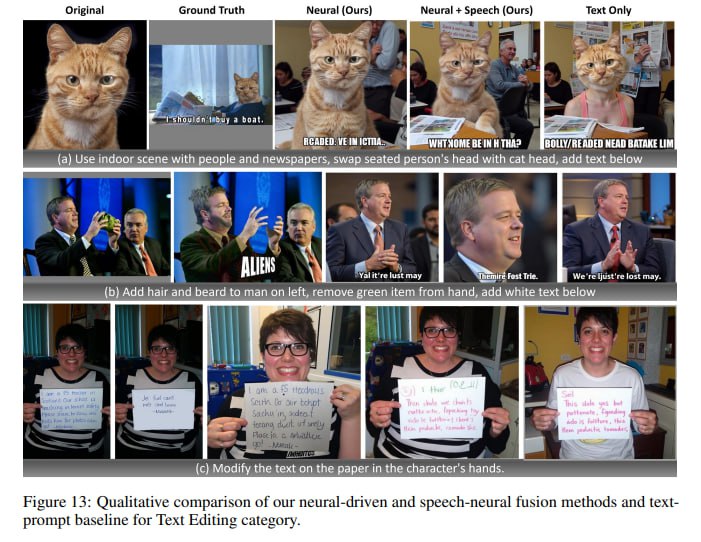

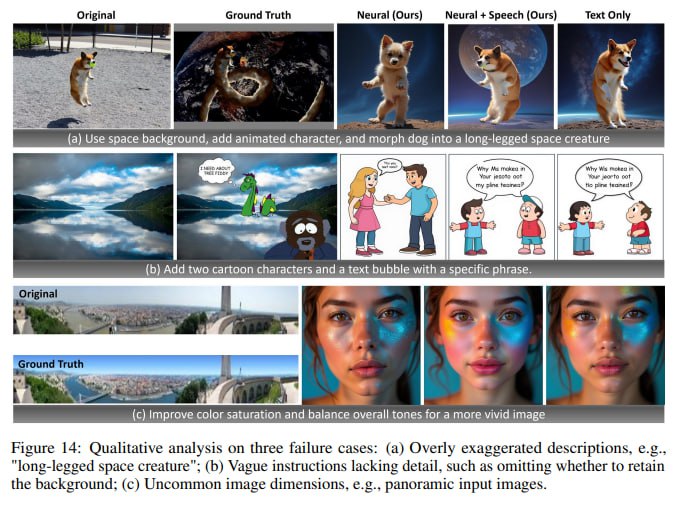

LoongX — будущее txt2img? Только вот оно наступит уже без использования текста. Надеваешь беспроводной BCI (brain-computer interface), фантазируешь себе картинку — и готово. LoongX хорошо так приблизился к этому, но пока в сфере редактирования изображений (img2img). На вход подаются данные с электроэнцефалограммы (ЭЭГ), функциональной ближней инфракрасной спектроскопии (fNIRS), фотоплетизмографии (PPG) и датчиков движения головы. Проще говоря, система считывает сигналы мозга, изменения кровотока, пульс и движения. Каждый сигнал несёт свой смысл: ЭЭГ отвечает за само намерение, fNIRS — за когнитивную нагрузку и эмоции, а PPG и движение — за стресс и вовлечённость. В комбинации с речью LoongX обходит текстовый метод OminiControl по семантическому соответствию (CLIP-T: 0.2588 против 0.2549). Что ещё интереснее, чисто нейронные сигналы (без речи) превосходят текст в структурной точности (DINO: 0.4812 против 0.4636) и семантической схожести с целевым изображением (CLIP-I: 0.6605 против 0.6558). Это большой шаг к тому, чтобы научиться интерпретировать и оцифровывать нашу фантазию напрямую. Ещё немного, и (возможно, не без помощи Neuralink и подобных) мы сможем транслировать свои фантазии прямо на экран, минуя потери при текстовом описании. У всех же было, когда пытаешься что-то нарисовать: в голове такая красивая картинка, а на бумаге выходит шляпа🤠 Давно вообще руками рисовали?) Кроме подробнейшей статьи нам дали датасет и код, в том числе тренировочный, что делает проект полностью опенсорсным, так что стоит ожидать еще больше подобных проектов. Project page Пейпер

NeuroVesti

LoongX — будущее txt2img?

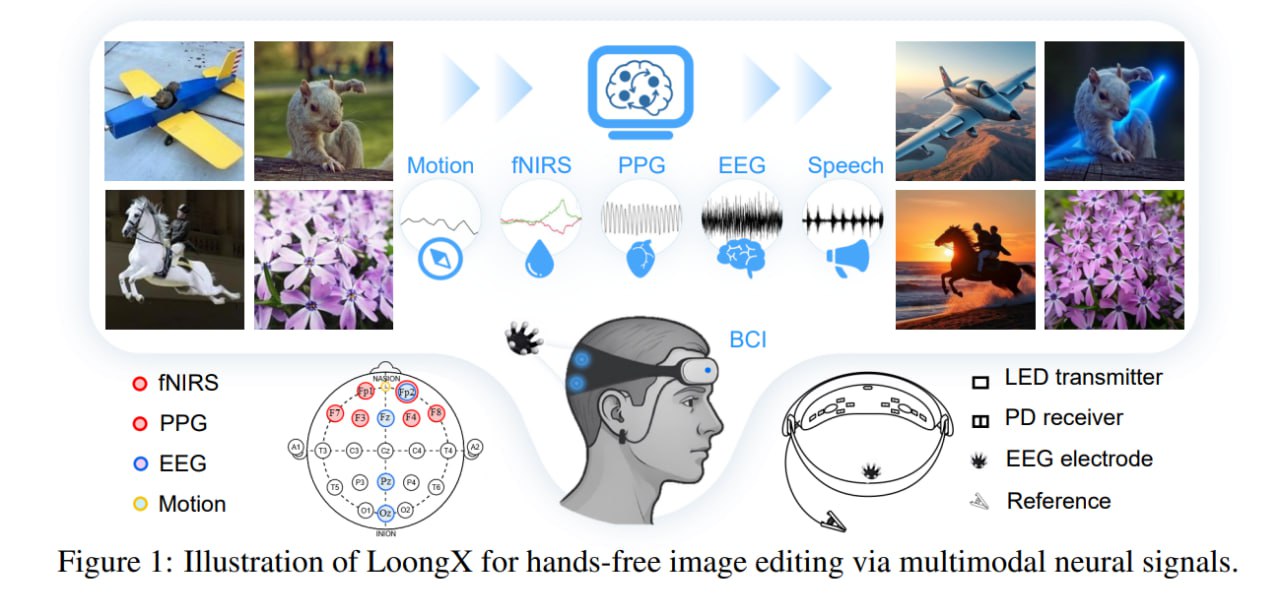

Только вот оно наступит уже без использования текста. Надеваешь беспроводной BCI (brain-computer interface), фантазируешь себе картинку — и готово.

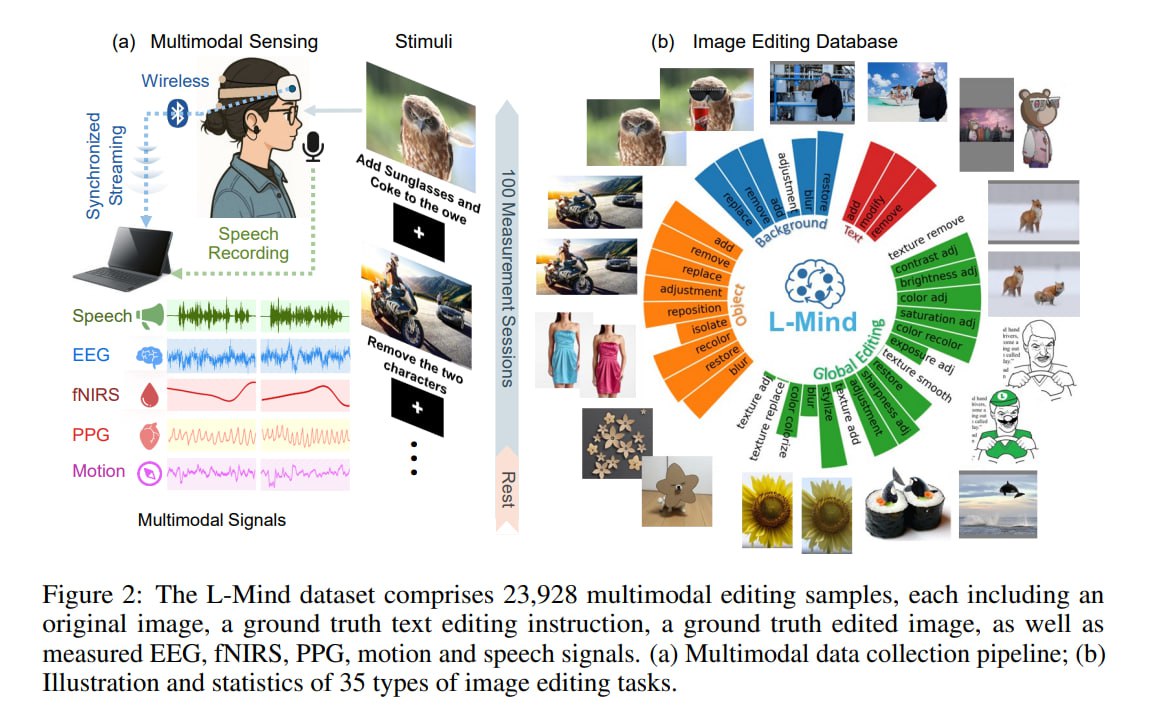

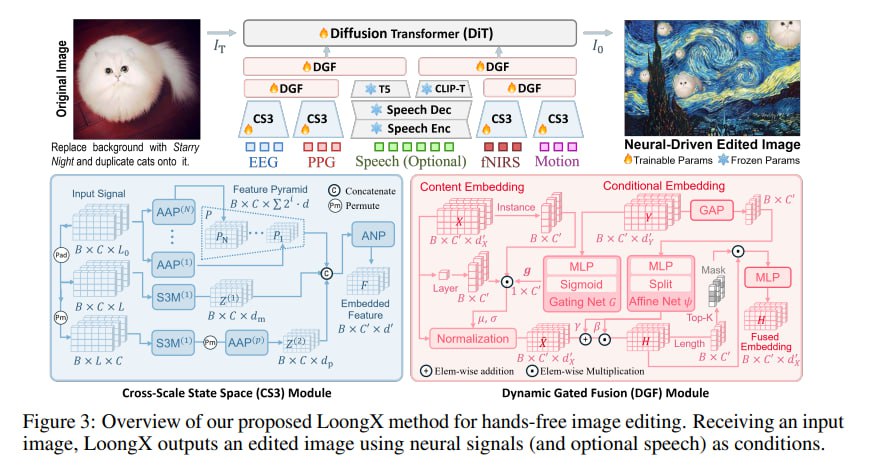

LoongX хорошо так приблизился к этому, но пока в сфере редактирования изображений (img2img). На вход подаются данные с электроэнцефалограммы (ЭЭГ), функциональной ближней инфракрасной спектроскопии (fNIRS), фотоплетизмографии (PPG) и датчиков движения головы. Проще говоря, система считывает сигналы мозга, изменения кровотока, пульс и движения.

Каждый сигнал несёт свой смысл: ЭЭГ отвечает за само намерение, fNIRS — за когнитивную нагрузку и эмоции, а PPG и движение — за стресс и вовлечённость.

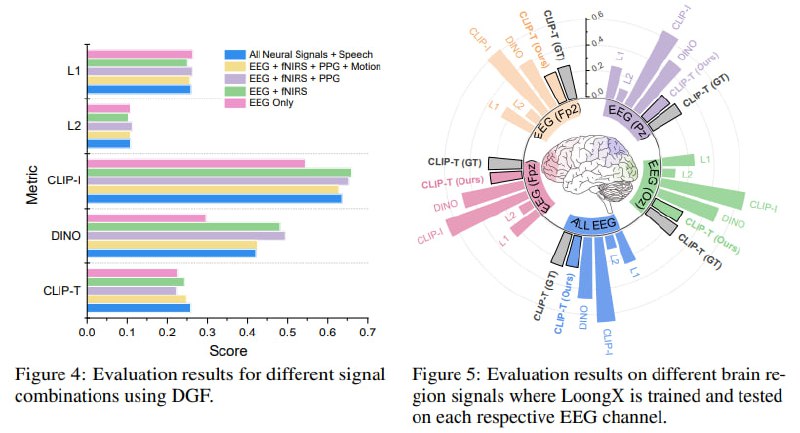

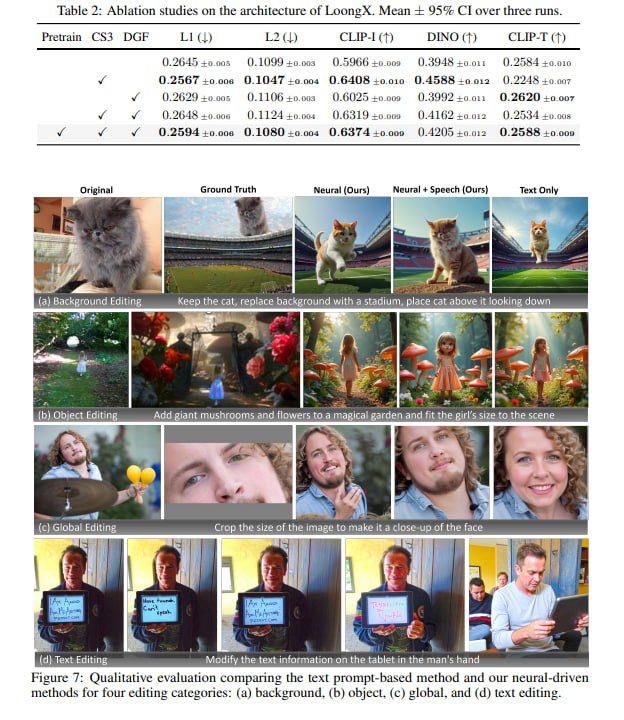

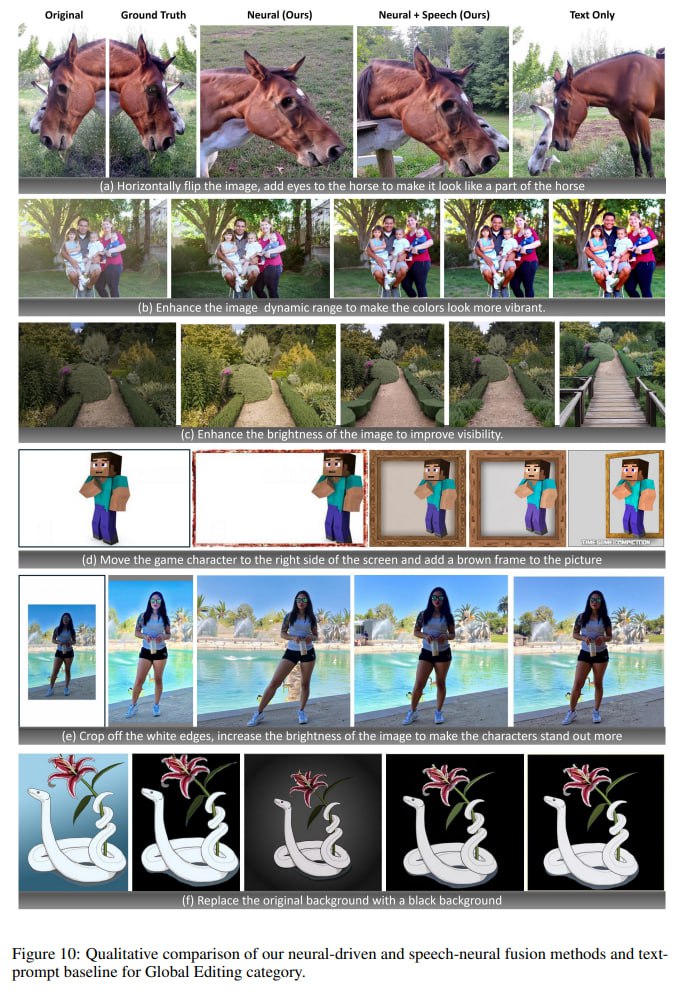

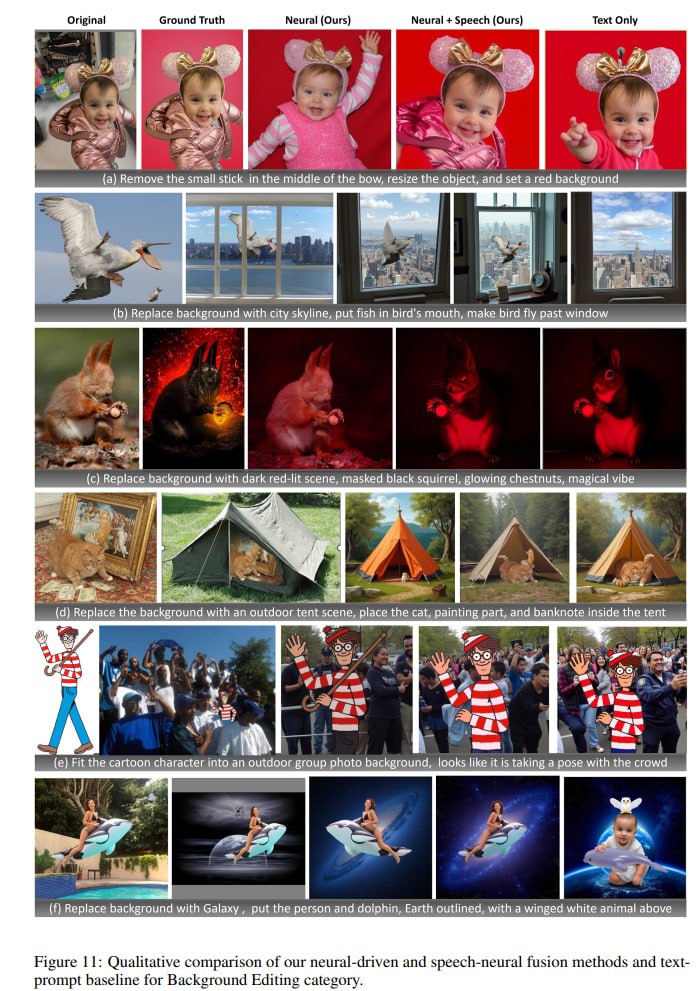

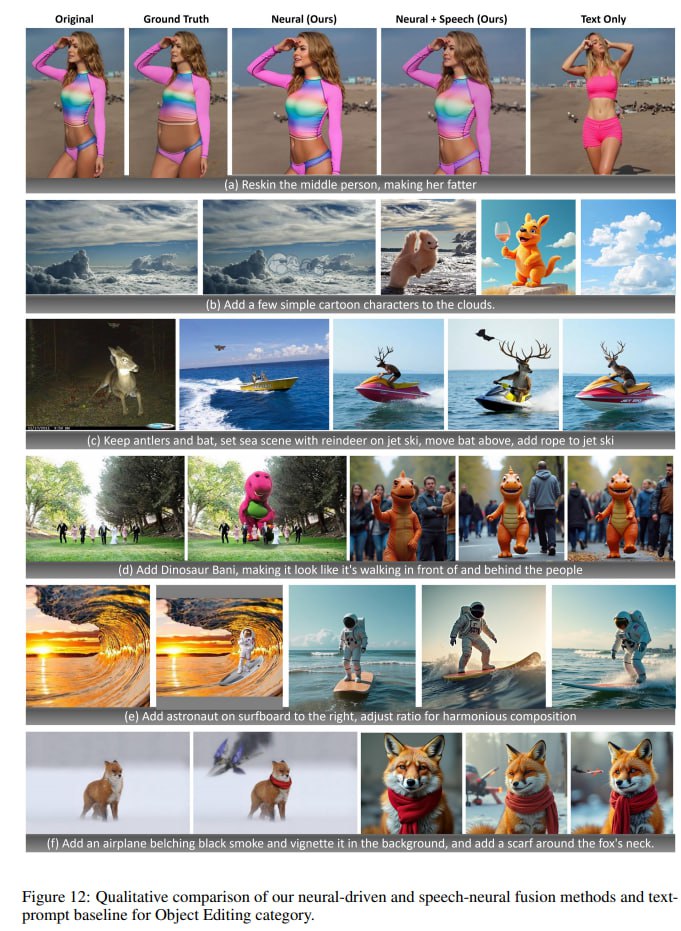

В комбинации с речью LoongX обходит текстовый метод OminiControl по семантическому соответствию (CLIP-T: 0.2588 против 0.2549). Что ещё интереснее, чисто нейронные сигналы (без речи) превосходят текст в структурной точности (DINO: 0.4812 против 0.4636) и семантической схожести с целевым изображением (CLIP-I: 0.6605 против 0.6558).

Это большой шаг к тому, чтобы научиться интерпретировать и оцифровывать нашу фантазию напрямую. Ещё немного, и (возможно, не без помощи Neuralink и подобных) мы сможем транслировать свои фантазии прямо на экран, минуя потери при текстовом описании. У всех же было, когда пытаешься что-то нарисовать: в голове такая красивая картинка, а на бумаге выходит шляпа🤠 Давно вообще руками рисовали?)

Кроме подробнейшей статьи нам дали датасет и код, в том числе тренировочный, что делает проект полностью опенсорсным, так что стоит ожидать еще больше подобных проектов.

Project page

Пейпер

LoongX — будущее txt2img?

Только вот оно наступит уже без использования текста. Надеваешь беспроводной BCI (brain-computer interface), фантазируешь себе картинку — и готово.

LoongX хорошо так приблизился к этому, но пока в сфере редактирования изображений (img2img). На вход подаются данные с электроэнцефалограммы (ЭЭГ), функциональной ближней инфракрасной спектроскопии (fNIRS), фотоплетизмографии (PPG) и датчиков движения головы. Проще говоря, система считывает сигналы мозга, изменения кровотока, пульс и движения.

Каждый сигнал несёт свой смысл: ЭЭГ отвечает за само намерение, fNIRS — за когнитивную нагрузку и эмоции, а PPG и движение — за стресс и вовлечённость.

В комбинации с речью LoongX обходит текстовый метод OminiControl по семантическому соответствию (CLIP-T: 0.2588 против 0.2549). Что ещё интереснее, чисто нейронные сигналы (без речи) превосходят текст в структурной точности (DINO: 0.4812 против 0.4636) и семантической схожести с целевым изображением (CLIP-I: 0.6605 против 0.6558).

Это большой шаг к тому, чтобы научиться интерпретировать и оцифровывать нашу фантазию напрямую. Ещё немного, и (возможно, не без помощи Neuralink и подобных) мы сможем транслировать свои фантазии прямо на экран, минуя потери при текстовом описании. У всех же было, когда пытаешься что-то нарисовать: в голове такая красивая картинка, а на бумаге выходит шляпа🤠 Давно вообще руками рисовали?)

Кроме подробнейшей статьи нам дали датасет и код, в том числе тренировочный, что делает проект полностью опенсорсным, так что стоит ожидать еще больше подобных проектов.

Project page

Пейпер

Дата публикации: 16.07.2025 10:33