Cohere Command A - техрепорт Вышел подробнейший техрепорто от Cohere, где они делятся рецептами по обучению современных LLM. Модель Command A с 111B параметров разработана для специфических корпоративных задач, а не для конкуренции с frontier-моделями от Гугла и OpenAI. Модель вышла пару недель назад, а вот техрепорт только подоспел. Вот ключевые моменты: ➡️ Цель Cohere: Создание умных, но эффективных моделей для корпоративных задач (RAG, многоязычность), которые можно развернуть локально (on-premise). ➡️ Архитектура: Стандартный плотный Transformer (SwiGLU, GQA), с 3:1 перемежающимися слоями локального и полного аттеншена (Gemma 3 использовала похожий трюк), но без позиционных эмбеддингов на full-attention и bias. ➡️ Обучение: Используются muP, различные виды параллелизма, FP8-тренировка с последующим "отжигом" (annealing) в BF16 для восстановления производительности и постепенным увеличением контекста до 256K. ➡️ Слияние моделей (Merging): Впервые кто-то из крупных игроков делится рецептами мерджинга. Они активно применяе слияник как на этапе SFT, так RL-тюна. Процесс: базовая instruct-модель -> 6 SFT-моделей по доменам (Код, RAG, Безопасность и т.д.) -> слияние -> 6 RL-моделей -> слияние -> финальный преференс тюн. Это упрощает разработку и позволило командам работать параллельно гад своими промежуточными моделями. ➡️ Данные: Основной упор на синтетические данные с оценкой людьми, с фокусом на RAG, использование инструментов (tool use), следование системным промптам и поддержку 23 языков. ➡️ Эффективность: Command A требует значительно меньше вычислительных ресурсов - модель можно засёрвить на 2x A100/H100 и бегает довольно шустро. Статья хорошо написана и легко читается. Там много других интересных деталей, дополняющих техрепорт о Llama 3 своим акцентом на пост-тренировку. Маст рид для тех, кто занимается тренировкой современных LLM! Тех Репорт

NeuroVesti

Cohere Command A - техрепорт

Вышел подробнейший техрепорто от Cohere, где они делятся рецептами по обучению современных LLM.

Модель Command A с 111B параметров разработана для специфических корпоративных задач, а не для конкуренции с frontier-моделями от Гугла и OpenAI. Модель вышла пару недель назад, а вот техрепорт только подоспел.

Вот ключевые моменты:

➡️ Цель Cohere: Создание умных, но эффективных моделей для корпоративных задач (RAG, многоязычность), которые можно развернуть локально (on-premise).

➡️ Архитектура: Стандартный плотный Transformer (SwiGLU, GQA), с 3:1 перемежающимися слоями локального и полного аттеншена (Gemma 3 использовала похожий трюк), но без позиционных эмбеддингов на full-attention и

bias.

➡️ Обучение: Используются muP, различные виды параллелизма, FP8-тренировка с последующим "отжигом" (annealing) в BF16 для восстановления производительности и постепенным увеличением контекста до 256K.

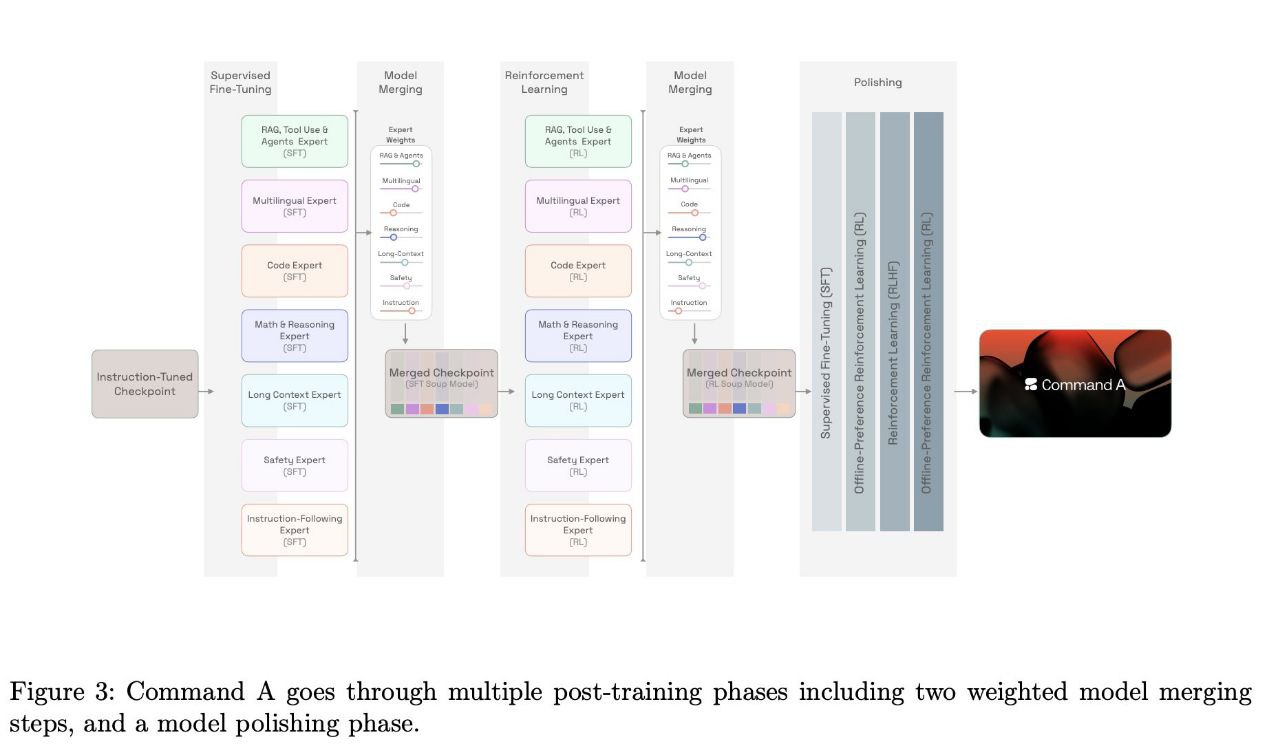

➡️ Слияние моделей (Merging):

Впервые кто-то из крупных игроков делится рецептами мерджинга. Они активно применяе слияник как на этапе SFT, так RL-тюна. Процесс: базовая instruct-модель -> 6 SFT-моделей по доменам (Код, RAG, Безопасность и т.д.) -> слияние -> 6 RL-моделей -> слияние -> финальный преференс тюн. Это упрощает разработку и позволило командам работать параллельно гад своими промежуточными моделями.

➡️ Данные: Основной упор на синтетические данные с оценкой людьми, с фокусом на RAG, использование инструментов (tool use), следование системным промптам и поддержку 23 языков.

➡️ Эффективность: Command A требует значительно меньше вычислительных ресурсов - модель можно засёрвить на 2x A100/H100 и бегает довольно шустро.

Статья хорошо написана и легко читается. Там много других интересных деталей, дополняющих техрепорт о Llama 3 своим акцентом на пост-тренировку. Маст рид для тех, кто занимается тренировкой современных LLM!

Тех Репорт

Cohere Command A - техрепорт

Вышел подробнейший техрепорто от Cohere, где они делятся рецептами по обучению современных LLM.

Модель Command A с 111B параметров разработана для специфических корпоративных задач, а не для конкуренции с frontier-моделями от Гугла и OpenAI. Модель вышла пару недель назад, а вот техрепорт только подоспел.

Вот ключевые моменты:

➡️ Цель Cohere: Создание умных, но эффективных моделей для корпоративных задач (RAG, многоязычность), которые можно развернуть локально (on-premise).

➡️ Архитектура: Стандартный плотный Transformer (SwiGLU, GQA), с 3:1 перемежающимися слоями локального и полного аттеншена (Gemma 3 использовала похожий трюк), но без позиционных эмбеддингов на full-attention и

bias.

➡️ Обучение: Используются muP, различные виды параллелизма, FP8-тренировка с последующим "отжигом" (annealing) в BF16 для восстановления производительности и постепенным увеличением контекста до 256K.

➡️ Слияние моделей (Merging):

Впервые кто-то из крупных игроков делится рецептами мерджинга. Они активно применяе слияник как на этапе SFT, так RL-тюна. Процесс: базовая instruct-модель -> 6 SFT-моделей по доменам (Код, RAG, Безопасность и т.д.) -> слияние -> 6 RL-моделей -> слияние -> финальный преференс тюн. Это упрощает разработку и позволило командам работать параллельно гад своими промежуточными моделями.

➡️ Данные: Основной упор на синтетические данные с оценкой людьми, с фокусом на RAG, использование инструментов (tool use), следование системным промптам и поддержку 23 языков.

➡️ Эффективность: Command A требует значительно меньше вычислительных ресурсов - модель можно засёрвить на 2x A100/H100 и бегает довольно шустро.

Статья хорошо написана и легко читается. Там много других интересных деталей, дополняющих техрепорт о Llama 3 своим акцентом на пост-тренировку. Маст рид для тех, кто занимается тренировкой современных LLM!

Тех Репорт

Дата публикации: 05.04.2025 11:12