Китайцы похоронили DeepSeek: QwQ-32B от Alibaba в разы превосходит навыки программирования любой другой модели — Код и математика решаются по щелчку пальцев. — 32 млрд параметров смогли обойти OpenAI с их 200 млрд, благодаря более точечным датасетам. — Мощностей хватит на огромные документы/книги, ИИ может скушать до 131.000 токенов контекста. Тест доступен по ссылке. NeuroTrends

NeuroVesti

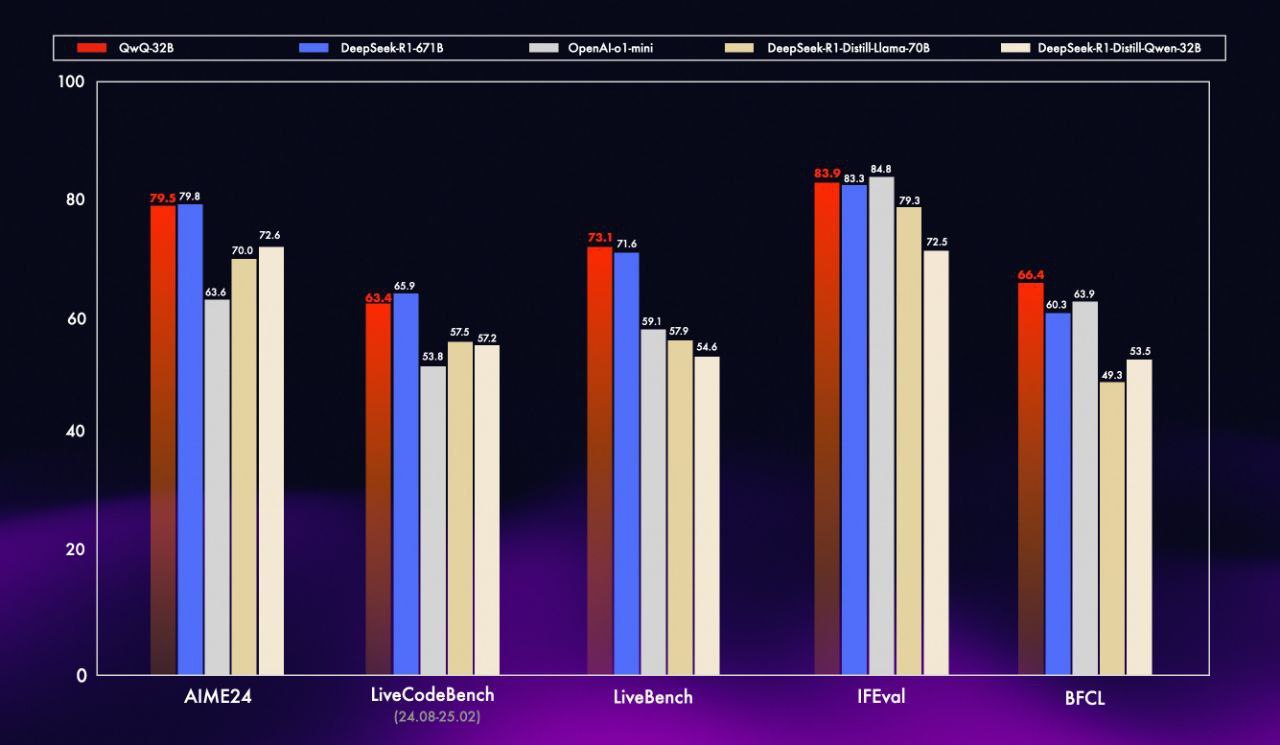

Китайцы похоронили DeepSeek: QwQ-32B от Alibaba в разы превосходит навыки программирования любой другой модели

— Код и математика решаются по щелчку пальцев.

— 32 млрд параметров смогли обойти OpenAI с их 200 млрд, благодаря более точечным датасетам.

— Мощностей хватит на огромные документы/книги, ИИ может скушать до 131.000 токенов контекста.

Тест доступен по ссылке.

NeuroTrends

Китайцы похоронили DeepSeek: QwQ-32B от Alibaba в разы превосходит навыки программирования любой другой модели

— Код и математика решаются по щелчку пальцев.

— 32 млрд параметров смогли обойти OpenAI с их 200 млрд, благодаря более точечным датасетам.

— Мощностей хватит на огромные документы/книги, ИИ может скушать до 131.000 токенов контекста.

Тест доступен по ссылке.

NeuroTrends

Дата публикации: 09.03.2025 11:00